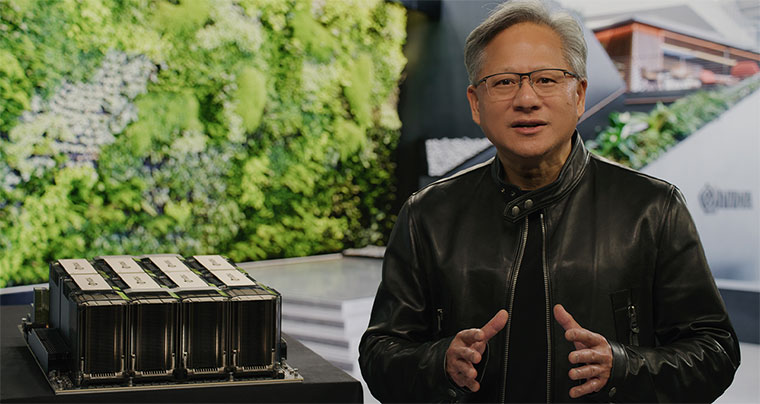

NVIDIA创始人兼首席执行官黄仁勋:NVIDIA将AI引入各行各业

ChatGPT仅是一个起点。

正如NVIDIA创始人兼首席执行官黄仁勋所说,计算正在以“光速”发展。黄仁勋于今日宣布与谷歌、微软、Oracle等一众领军企业开展广泛的合作,为各行各业带来新的AI、模拟和协作能力。

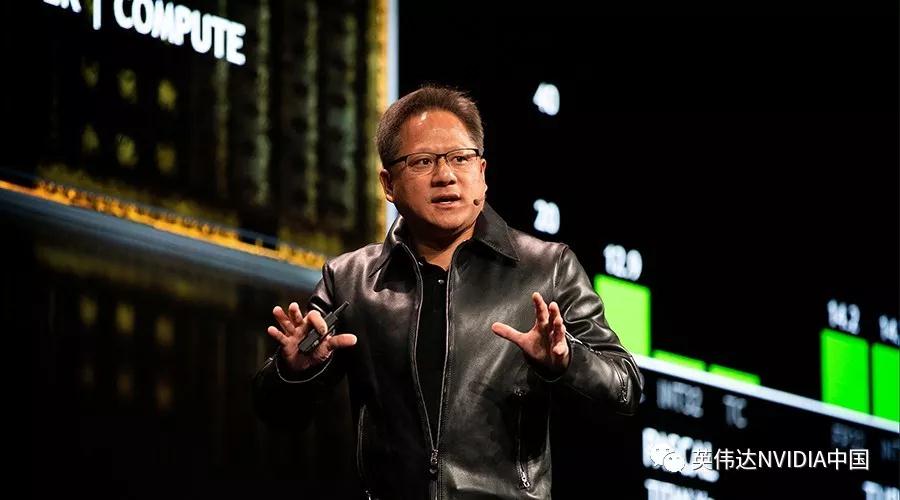

黄仁勋在NVIDIA GTC大会主题演讲中表示:“如果把加速计算比作曲速引擎,那么AI就是动力来源。生成式 AI 的非凡能力,使得公司产生了紧迫感,他们需要重新构思产品和商业模式。”

作为这场为期四天活动的主题演讲,黄仁勋在长达78分钟的演讲中概述了NVIDIA及其合作伙伴如何提供训练和部署尖端AI服务所需的各种技术。他发布了全新的半导体和软件库以推动行业新突破,以及一套完整的系统和服务,帮助各类初创公司及企业将这些创新在全球发挥作用。

黄仁勋在演讲中用生动的例子说明了该生态系统的作用。他宣布NVIDIA和微软将把数亿Microsoft 365和Azure用户连接到一个用于构建和操作超现实虚拟世界的平台,并介绍了亚马逊如何使用复杂的模拟能力训练新的自主仓库机器人。他还谈到ChatGPT等最近大火的新一代生成式AI服务的兴起。

在强调NVIDIA创新成果的基础作用时,黄仁勋详细介绍了NVIDIA在计算光刻技术领域所取得的突破,以及与ASML、TSMC和Synopsis的合作,这些将为制造高效、强大的新一代2纳米半导体奠定基础。

黄仁勋表示,加速计算和AI的出现恰逢其时。摩尔定律正在放缓,各个行业正在应对可持续发展,生成式AI以及数字化等强大的动态挑战。“各个行业的企业正在竞相进行数字化转型,希望成为软件驱动的技术公司,成为行业颠覆者而不是被颠覆者。”

加速计算可助力企业应对这些挑战。黄仁勋表示:“加速是重获优势、实现可持续发展,以及达到净零排放的最佳途径。”

GTC:行业领先的AI大会

进入到第14个年头的GTC已成为全球最重要的AI大会之一。本次大会有超过650场会议,演讲嘉宾包括来自DeepMind、Adobe、Netflix、苏黎世联邦理工学院等企业和机构的行业领导者,此外,本届大会还有一场黄仁勋和OpenAI联合创始人Ilya Sutskever的炉边谈话,ChatGPT正是OpenAI的产品。

超过25万名注册用户将深入参与GTC各个主题的会议,其中涵盖如何修复2000年前失传的罗马马赛克、建造未来工厂、用新一代大型望远镜探索宇宙、通过重新排列分子加速药物研发、以及70多场关于生成式AI的讲座等。

AI的 iPhone时刻

NVIDIA技术是AI的基础,黄仁勋讲述了NVIDIA如何在生成式AI变革初期就已参与进来。早在2016年,他就向OpenAI亲手交付了第一台NVIDIA DGX AI超级计算机——支持 ChatGPT 的大型语言模型突破背后的引擎。

去年年底推出的ChatGPT几乎在一夜之间爆火,吸引了超过1亿用户,成为有史以来增长最快的应用。黄仁勋认为 “我们正处于AI的 iPhone时刻 ”。

黄仁勋表示,最初作为AI研究仪器使用的NVIDIA DGX超级计算机现已在世界各地的企业中全天候运行,用于完善数据和处理AI。《财富》100强企业中有一半都安装了DGX AI超级计算机。

“DGX超级计算机是现代AI工厂”。

用于数据中心的NVIDIA H100、Grace Hopper和Grace

黄仁勋表示,类似ChatGPT大型语言模型(LLM)的部署是一个重要的全新推理工作负载。为了支持像ChatGPT这样的大型语言模型推理,黄仁勋发布了一款新的GPU——带有双GPU NVLink的H100 NVL。

基于NVIDIA Hopper架构的H100配有一个Transformer引擎,旨在处理驱动ChatGPT的类似GPT模型。与用于GPT-3处理的HGX A100相比,配备四对H100与双GPU NVLink的标准服务器的速度最高可达10倍。

黄仁勋表示:“H100可以将大型语言模型的处理成本降低一个数量级。”

在过去十年中,云计算每年增长20%并已发展成为一个万亿美元的产业。NVIDIA为这个AI和云优先的世界设计了Grace CPU,其中AI工作负载由GPU加速。Grace正在进行样品调测。

通过900GB/s高速芯片对芯片的接口,NVIDIA Grace Hopper超级芯片可连接Grace CPU和Hopper GPU。黄仁勋解释说,“ Grace Hopper是处理超大型数据集的理想选择,比如用于推荐系统的AI数据库和大型语言模型。”

“客户希望构建规模大几个数量级的AI数据库,那么Grace Hopper是最理想的引擎。”

DGX是构建AI基础设施的蓝图

最新版本的DGX搭载8个NVIDIA H100 GPU,它们连接成为一个巨大的GPU。黄仁勋表示:“NVIDIA DGX H100是全球客户构建AI基础设施的蓝图”,现已全面投入生产。

H100 AI超级计算机现已开始上线。Oracle Cloud Infrastructure宣布配备 H100 GPU 的新 OCI Compute 裸机 GPU 实例在一定条件可用。

此外,亚马逊云科技发布了即将推出的P5实例 EC2 UltraClusters,其规模可扩展到2万个互连的H100 GPU。

上周,微软 Azure 发布了其 H100 虚拟机 ND H100 v5 的私人预览版。

Meta 现已为其内部的 AI 生产和研究团队部署了由 H100 驱动的 Grand Teton AI 超级计算机。

OpenAI 将在其 Azure 超级计算机上使用 H100来支持其持续进行的AI研究。

提供 H100 的其他合作伙伴包括 Cirrascale 和 CoreWeave,这两家公司今天都宣布全面上市。此外,Google Cloud、Lambda、Paperspace 和 Vult 都计划提供 H100。